NVIDIA宣布对NeMoMegatron框架进行更新,该框架可将大型语言模型的AI训练速度提高30%。新闻稿:随着大型语言模型(LLM)的规模和复杂性不断增长,NVIDIA今天宣布对NeMoMegatron框架进行更新,该框架可提供高达30%的训练速度提升。

这些更新包括两项开创性技术和一个超参数工具,可在任意数量的GPU上优化和扩展LLM的训练,提供使用NVIDIAAI平台训练和部署模型的新功能。

BLOOM是世界上最大的开放科学、开放获取的多语言语言模型,拥有1760亿个参数,最近在NVIDIAAI平台上进行了训练,支持46种语言和13种编程语言的文本生成。NVIDIAAI平台还支持拥有5300亿个参数的最强大的Transformer语言模型之一,即Megatron-TuringNLG模型(MT-NLG)。

LLM是当今最重要的先进技术之一,涉及从文本中学习的多达数万亿个参数。然而,开发它们是一个昂贵且耗时的过程,需要深厚的技术专长、分布式基础设施和全栈方法。

适用于TeslaV100SXM3GPU的NVIDIAHGX2GPU(图形处理单元)托盘环。该公司的HGX基板与其A100TensorCoreGPU配对,一些人担心如果NVIDIA收购设计公司,Arm产品可能会面临类似的命运。图片:浪潮集团

然而,它们在推进实时内容生成、文本摘要、客户服务聊天机器人和对话式AI界面问答方面的好处是巨大的。

为了推进LLM,AI社区正在继续对MicrosoftDeepSpeed、Colossal-AI和HuggingFaceBigScience等工具进行创新,这些工具均由NVIDIAAI平台提供支持,包括Megatron-LM、Apex和其他GPU加速库。

这些对NVIDIAAI平台的新优化有助于解决整个堆栈中的许多现有痛点。NVIDIA期待与AI社区合作,继续让所有人都能获得LLM的力量。

NeMoMegatron的最新更新为GPT-3模型的训练提供了30%的加速,其参数范围从220亿到1万亿不等。现在可以在24天内使用1,024个NVIDIAA100GPU在1750亿个参数模型上完成训练——在这些新版本发布之前,将获得结果的时间缩短10天,或大约250,000小时的GPU计算。

NeMoMegatron是一个快速、高效且易于使用的端到端容器化框架,用于收集数据、训练大型模型、根据行业标准基准评估模型以及以最先进的延迟进行推理和吞吐量性能。

它使LLM训练和推理在各种GPU集群配置上变得容易且可重现。目前,这些功能可供早期访问客户在NVIDIADGXSuperPOD和NVIDIADGXFoundry以及MicrosoftAzure云中运行。对其他云平台的支持即将推出。

您可以在NVIDIALaunchPad上试用这些功能,这是一个免费程序,提供对NVIDIA加速基础设施动手实验室目录的短期访问。

两种加速LLM培训的新技术

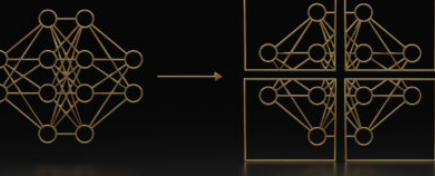

更新中包含的两项用于优化和扩展LLM训练的新技术是序列并行性(SP)和选择性激活重新计算(SAR)。

序列并行性扩展了张量级模型并行性,它注意到以前没有被并行化的转换器层的区域在序列维度上是独立的。

沿着序列维度拆分这些层可以实现计算的分布,最重要的是,这些区域的激活内存可以跨张量并行设备。由于激活是分布式的,因此可以为反向传递保存更多的激活,而不是重新计算它们。

选择性激活重新计算通过注意到不同的激活需要不同数量的操作来重新计算,从而改善了内存限制强制重新计算一些但不是全部激活的情况。

除了检查点和重新计算整个转换器层之外,还可以检查点和重新计算每个转换器层的一部分,这些部分占用大量内存,但重新计算的计算成本并不高。

获得LLM的强大功能还需要高度优化的推理策略。用户可以轻松地使用经过训练的模型进行推理,并使用p-tuning和提示调整功能针对不同的用例进行优化。

标签:

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!